自动驾驶包括感知、判断和执行,而感知是整个过程的源头,是自动驾驶系统的重要模块。在车辆行车过程中,感知系统会通过传感器实时采集周边环境的信息,相当于自动驾驶汽车的「眼睛」,可以帮助汽车实现类似于人类驾驶员一样效果的观察能力。

在自动驾驶车辆中,感知系统主要由摄像头、毫米波雷达、激光雷达(可选,这里主要是怕被特斯拉的粉丝杠)等传感器构成。摄像头作为主要的环境感知传感器起着非常重要的作用, 可以实现 360° 全面视觉感知,弥补雷达在物体识别上的缺陷,是最接近人类视觉的传感器。因此是车载摄像头是自动驾驶领域的关键设备之一。

本文来自汽车智能网联技术青年专家程增木老师为我们带来车载摄像头的技术入门介绍、目前主流的车型车载摄像头搭载方案的优劣比较和未来车载摄像头的发展趋势。

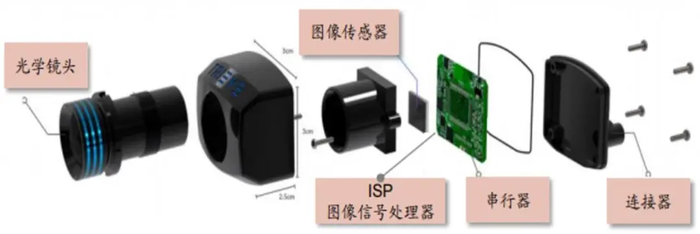

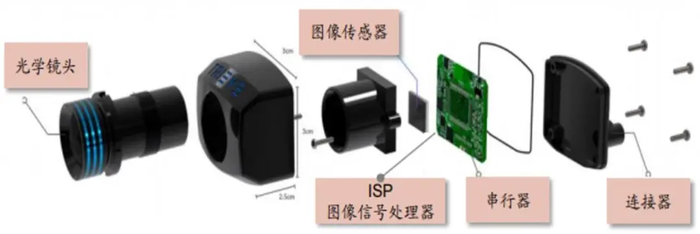

车载摄像头主要的硬件结构包括光学镜头(其中包含光学镜片、滤光片、保护膜等)、图像传感器、图像信号处理器 ISP、串行器、连接器等器件。其结构示意图如图所示:

车载摄像头的结构构成(图片来源:安森美半导体公司)

光学镜头:

负责聚焦光线,将视野中的物体投射到成像介质表面,根据成像效果的要求不同,可能要求多层光学镜片。滤光片可以将人眼看不到的光波段进行滤除,只留下人眼视野范围内的实际景物的可见光波段。

图像传感器:

图像传感器可以利用光电器件的光电转换功能将感光面上的光像转换为与光像成相应比例关系的电信号。主要分为 CCD 和 CMOS 两种。

ISP 图像信号处理器:

主要使用硬件结构完成图像图传感器输入的图像视频源 RAW 格式数据的前处理,可转换为 YCbCr 等格式。还可以完成图像缩放、自动曝光、自动白平衡、自动聚焦等多种工作。

串行器:

将处理后的图像数据进行传输,可用于传输RGB、YUV等多种图像数据种类。

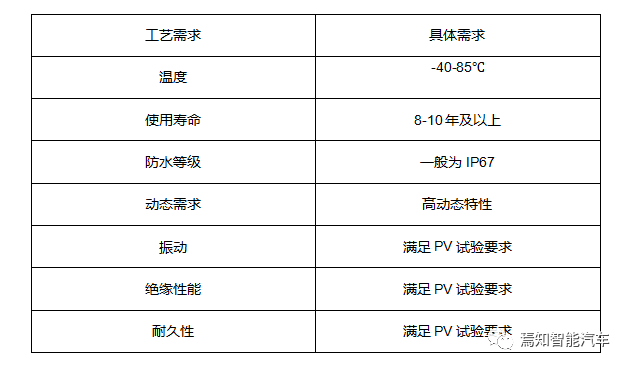

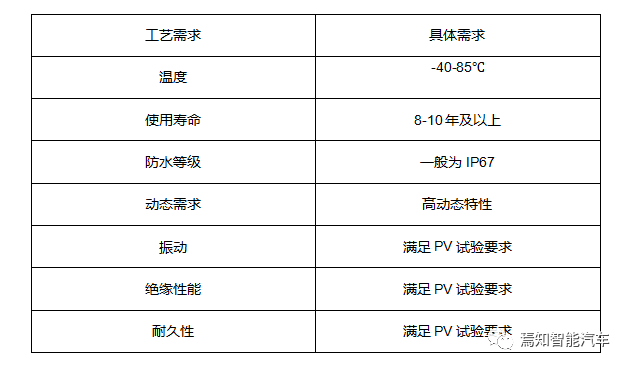

车载摄像头在制造工艺及可靠性要求方面也要高于工业摄像头和商用摄像头,由于汽车需长期工作在恶劣环境中,车载摄像头需要在高低温环境、强振动、高湿热等复杂工况环境下稳定工作,对于工艺制造方面的要求主要如下:

车载摄像头的工艺需求

目前车上搭载的车载摄像头根据安装位置主要分为车载摄像头主要分为前视摄像头、环视摄像头、后视摄像头、侧视摄像头以及内置摄像头五种类别。

前视摄像头:

主要安装在前挡风玻璃上,用于实现行车的视觉感知及识别功能,根据功能又可以分为前视主摄像头、前视窄角摄像头和前视广角摄像头。

前视主摄像头:

该摄像头在 L2 的 ADAS 系统中作为主摄像头使用。其视场角的一般为 30°、50°、60°、100°、120°,检测距离一般为 150 - 170 m,摄像头输出的格式为 RCCB 或 RCCC。

前视广角摄像头:该摄像头的作用主要是识别距离较近的物体,主要用于城市道路工况、低速行驶等场景,其视场角在 120° - 150°,检测距离在 50 m 左右。在后续 8MP 镜头大规模装车后,无需该摄像头。

前视窄角摄像头:

该摄像头的主要作用是进行红绿灯、行人等目标的识别,一般选用窄角镜头,可选择 30 - 40° 左右的镜头。并且该镜头的像素一般和前视主摄像头的镜头像素一致,该摄像头采用窄角度,具有更高的像素密度和更远的检测距离,一般可达 250 m 甚至可探测更远的距离。

在上了 8MP 摄像头后,前视主摄像头的 FOV 可达 120°,该摄像头可能就不需要了。检测距离在 60 m 左右。

环视摄像头:

主要安装在车身四周,一般使用 4 - 8 个摄像头,可分为前向鱼眼摄像头/左侧鱼眼摄像头/右侧鱼眼摄像头/后向鱼眼摄像头。用于全景环视功能的显示,以及融合泊车功能的视觉感知及目标检测;常用色彩矩阵为 RGGB,因为有色彩还原的需求。

后视摄像头:

一般安装在后备箱上,主要是实现泊车辅助。视场角在 120 - 140° 之间,探测距离大概 50 m。

侧前视摄像头:

安装在 B 柱或者车辆后视镜处,该摄像头的视场角一般为 90° - 100°,探测距离大概在 80 m 左右,这个摄像头的主要作用是检测侧向车辆及自行车。

侧后视摄像头:

一般安装在车辆前翼子板处,该摄像头的视场角一般为 90° 左右,探测距离也在 80 m 左右,主要用于车辆变道、汇入其它道路等场景应用。

内置摄像头:

主要用于监测司机状态,实现疲劳提醒等功能。

其中,前视摄像头价格相对较高,目前市场价格处在 300 - 500 元水平;其余摄像头价格在 150 - 200 元左右。

特斯拉的 Autopilot 系统搭载了 8 个摄像头,其中前方摄像头模组共由 3 个摄像头组成,这 3 个摄像头都是基于 2015 年安森美半导体公司发布的 120 万像素图像传感器开发的,其配备了 3 个 AR0136A 上的 CMOS 图像传感器,像素大小为 3.75 um,分辨率为 1280×960(1.2MP)。

鱼眼镜头:

视野达 120 度的鱼眼镜头能够拍摄到交通信号灯、行驶路线上的障碍物和距离较近的物体,非常适用于城市街道、低速缓行的交通场景。

长焦距镜头:

视野相对较窄,适用于高速行驶的交通场景,并可以清晰拍摄远达 250 m 的物体。

前方侧视摄像头:

视场角为 90°,前方侧视摄像头分别位于特斯拉两侧的 B 柱上,最大探测距离为 80 m。其能够探测到高速公路上突然并入当前车道的车辆,以及在进入视野受限的交叉路口时进行探测。

侧方后视摄像头:

最大探测距离为 100 m,能监测车辆两侧的后方盲区,在变道和汇入高速公路时起着重要作用。

后视摄像头:

探测距离为 50 m,主要进行泊车辅助。

小鹏 P7 搭载了 14 个摄像头,我们选择其中最重要的几个摄像头讲解。

前方摄像头模组

共由 3 个摄像头组成,这 3 个摄像头都是 200 万像素,帧率为 15/60 fps。

其中分为远距感知摄像头:视场角为 28°,是窄视角的前向摄像头,可探测 150 米以上的路面情况。

中距感知摄像头:

视场角为 52°,是主要的前向摄像头,可探测 30 - 70 m 的范围。

远距离感知摄像头:

视场角为 100°,可探测 40 m 的范围。

小鹏 P7 的侧前视摄像头安装在后视镜处,视场角为 100°,100 万像素,分辨率是 457*237,fps 为 30,用于防加塞和侧向车辆的检测。

小鹏 P7 的后视侧边摄像头安装在翼子板上,参数与侧视摄像头差不多,用于ALC(自动变道)、开门预警和盲区检测。

小鹏 P7 的后视摄像头安装在后备箱处,视场角为 52°,200 万像素,fps 为 30,用于 ALC、盲区检测和追尾预警。

奔驰 S 级搭载了 7 个摄像头,其中前方摄像头模组共由 2 个双目立体摄像头组成,这 2 个摄像头的像素均为 1.3MP,其镜头光轴之间的距离大概在 22 - 25 cm 左右,探测的有效距离大约为 120 m,摄像头的视场角大约在 50° 左右,刷新频率在 10Hz 左右。

供应商为大陆汽车电子,该双目摄像头可完成 3D 立体识别功能,可以完成目标跟踪、位置预测并且配合毫米波雷达实现目标速度的检测。

奔驰 S 级在保险杠处安装了一个摄像头,该摄像头是前向鱼眼摄像头,视场角约为 120°,配合其它视像头实现 360° 环视功能。

奔驰 S 级前鱼眼摄像头

奔驰 S 级在两个后视镜处各安装了一个摄像头,该摄像头是侧向鱼眼摄像头,视场角约为 120°,配合其它视像头实现 360° 环视功能。

奔驰 S 级侧视鱼眼摄像头

奔驰 S 级的的后视摄像头安装在后备箱处,视场角约为 120°,200 万像素,配合其它视像头实现 360° 环视功能。

奔驰 S 级后视鱼眼摄像头

从方案中我们可以看到,特斯拉的 8 个摄像头均与行车系统有关联,这与其一直宣传的不依靠激光雷达纯视觉的自动驾驶方案是有较大关联的,特斯拉的这一套方案的最大优势就是:高性价比。特斯拉用了成本非常低的自研 1.2MP 摄像机就实现了 L2+ 级别的自动驾驶。

小鹏 P7 使用了多个摄像头,这一套方案的最大优势就是:可拓展性较强。前期方案在设计时需要提高硬件成本,但是在后期 OTA 升级后,其自动驾驶功能具有非常好的兼容性和可拓展性。

通过这套传感器模型,小鹏实现了具有较好体验的 L2+ 级别的自动驾驶功能,包括小鹏极具特色的高速自主导航驾驶(NGP)和停车场记忆泊车功能。

奔驰 S 级是传统主机厂方案的代表,双目立体摄像头方案是奔驰 S 级最大的优势。相比于单目摄像头,双目摄像头可以计算当前检测目标在 X、Y、Z 坐标下的运动情况,判断检测目标的姿态及目标类型,奔驰在 L2 级别的 ADAS 功能的体验效果也比另外两家好一些。

从上文对已经量产车型的摄像头方案分析中,我们发现其都是使用中低像素摄像头来实现自动驾驶功能。随着技术的发展与更新,未来更多量产车型及自动驾驶解决方案会使用 800 万摄像头。

800 万像素相对于 120 万像素的摄像头,它可以探测到 100 - 150 m 范围内的行人,并且在窄视角的场模式情况下,大约可以探测到 500 m 左右的动态车辆,180 m 左右的小目标。

2018 年德国大陆集团就发布了 800 万像素的摄像头 MFC535,这款摄像头的视场角为 125°,并且可以识别 100 m 的交通标志,140 m 的自行车、行人, 160 m 的摩托车和三轮车,250 m 的轿车,这款摄像头的性能不错,可以有效提升车辆的感知性能并且应对最新的 Euro NCAP 安全标准。

MFC535 可利用深度学习方法,识别人体的四肢、背包、五官,并判别出行人的姿态,包括但不限于行、坐、卧、立等状态,以及判断出大人还是小孩。

豪威科技在 2019 年发布了 2 款 800 万像素前向摄像头 OX08A 和 OX08B。两款摄像头都具有非常良好的高动态范围(HDR),并且在芯片上集成于了 HALE(HDR 和 LFM 引擎)合成算法,OX08B 还具有非常优秀的 LED 闪烁抑制(LFM)性能。

这两款摄像头都可以提供 4 次读取 HDR、3840x2160 图像分辨率(8MP)、36 fps、16:9 比例的图像,同时提供多种 CFA 排列来满足自动驾驶的性能需求,可以准确探测远处的人和物体,并且可以满足极暗或极亮环境下的应用需求(例如驶出隧道)。这两款摄像头都满足 ASIL-C 功能安全要求。

对于车规级 800 万像素的摄像头,目前国内蔚来 ET7、2021 款理想 ONE 极氪 001 等车型在使用。

2021 年 1 月蔚来发布了 ET7,这款车的一大亮点就是搭载了 11 颗 800 万像素的高清摄像头。ET7 基于 NT2.0 平台打造,前向摄像头有 4 颗,环视摄像头为 4 颗,感知摄像头为 3 颗。

蔚来的 11 颗摄像头的供应商为均胜电子,这颗 800 万像素的高清摄像头可以最远探测 687 m 左右的车辆,262 m 左右的锥桶,223 m 左右的人。摄像头分别分布在前保险杠、后视镜、翼子板、后备箱、鲨鱼鳍、车顶部。

2021 款理想 ONE 在国内市场正式首发,该车搭载了 800 万像素前视摄像头,识别精度达到 4K 级别,有效可视距离约为 200 m ,视场角为 120°。

理想800万像素前置摄像头模组(来源汽车之家)

2021 年发布的极氪 001 使用了 15 个摄像头,其中 12 个摄像头用于自动驾驶,其中 8 个远距离摄像头都是使用 800 万像素的高清摄像头,可以覆盖车辆感知全视野区域。

一个 800 万像素的 16 位前视摄像头,以每秒 60 帧的速度运行,数据速率可达 1GB/s。800 万像素的摄像头,每秒钟需要处理的数据量是巨大的,同时对于不同场景和不同的神经网络,耗费的算力也不一样。

在日后 800 万像素摄像头成为标配后,计算平台也需提升自己的算力。单个 800 W 在使用 FP16 精度数据的情况下,摄像头的数据速率为 1GB/S,在内存带宽为 64GB/S,供电电压和温度情况均正常,其算力需求主要集中在深度学习模型的 batch 尺寸中。

假设使用 ResNet-50 进行图像处理,每秒需处理 1 GB 的数据图像量,大概可以处理 159 张图像,该网络在「修枝」后需要大约每秒 70 亿次的运算,粗略估计需要 1.14 TOPS 的算力。(以上情况为简单估算)

由此可见,升级了 800 万像素后,随着深度学习网络的发展,其对算力具有更高的要求。

蔚来超算平台 NIO Adam 使用了 4 颗 NVIDIA Drive Orin 芯片,包括 2 颗主控芯片 + 1 颗冗余备份芯片 + 1 颗群体智能与个性训练专用芯片,算力最高为 1016 TOPS,并且有超高带宽的图像接口,ISP 每秒可处理64亿像素。这对于使用 11 颗 800 万摄像头的 ET7 来说性能是足够的。

2021 款理想 ONE 使用地平线征程 3 芯片,这款芯片基于台积电 16nm FFC 工艺,使用双核 BPU AI 引擎,等效算力 ≥ 5 TOPS;使用 4 核 Arm Cortex-A53 处理器,支持 4K@30fps 图像处理、HDR 宽动态、3D 降噪以及畸变矫正。

极氪 001 使用 2 颗 Mobileye EyeQ5H,使用台积电的 7 nm FinFET 工艺打造,单颗芯片算力为 24 TOPS。

使用 800W 像素摄像头后带来的一个比较大的问题就是过多的数据量,在融合和处理时可以借助一些方法进行处理。作者在阅读大量文献后,推荐使用 CenterNet 网络的处理思路对多目标、多数据量进行处理。

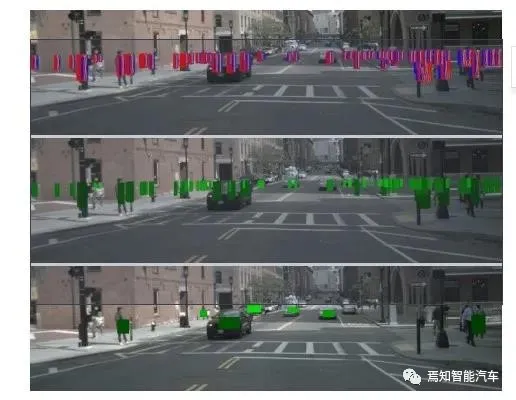

上图展示的核心方法就是使用 CenterNet 算法进利用摄像头数据预测目标的中心点,并回归得到目标的 3D 坐标、深度、旋转等信息。高像素摄像机适合使用 CenterNet,相对于之前的 one-stage 和 two-stage 的目标检测,基于高分辨率的图像输入,图像传输的物体的特征可提取性较好,CenterNet的「anchor」仅仅会出现在当前需检测的目标(例如行人、车辆等)的位置处而不是整张图,在高分辨率图像的支持下可以精准地直接检测目标的中心点和大小。

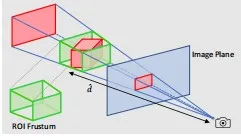

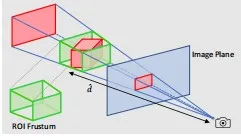

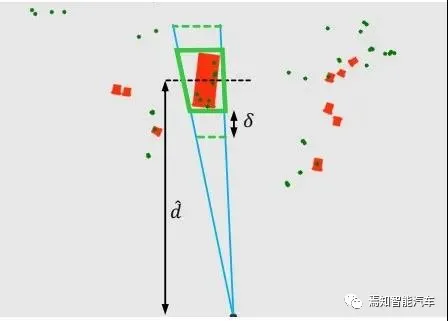

随后将高精度摄像头的检测的目标中心点数据和激光雷达采集到的目标数据进行关联,可以采用视锥的方法进行关联。可以基于对象的三维边界生成 ROI 的截锥体,如下图所示。

ROI 的截锥体(来源:CenterFusion: Center-based Radar and Camera Fusion for 3D Object Detection)

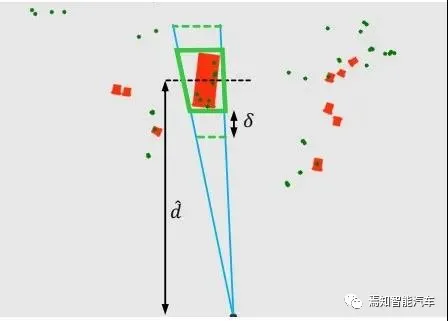

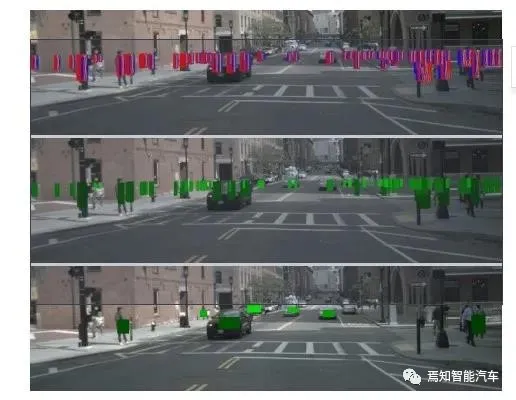

边界生成 ROI 的截锥体的 BEV 与雷达检测到的特征进行融合,最终显示如下图。

ROI 的截锥体的 BEV 与雷达检测到的特征融合图(来源:CenterFusion: Center-based Radar and Camera Fusion for 3D Object Detection)

随后将关联后的目标的特征和雷达数据检测到的深度和速度信息组成的特征图并联,再进行 3D 目标深度、旋转、速度和属性的回归。

算法检测结果图(来源:CenterFusion: Center-based Radar and Camera Fusion for 3D Object Detection)

随后将关联后的目标的特征和雷达数据检测到的深度和速度信息组成的特征图并联,再进行 3D 目标深度、旋转、速度和属性的回归。

作者在 nuScenes 数据集上进行了验证,该方法可显著提高检测精度。随着 800 万像素的车载摄像头日后的推广应用,随着检测图像的信息越来越丰富,精度越来越高,相信以后会有更多更高效、更快速的视觉检测网络及算法应用到汽车上。

摄像头的像素大幅提升,带来的不光光是对芯片算力等性能的要求,还带来了对于功率、热管理等层面的需求。为了实现更好的性能,摄像头需要更大功率的电源,因此摄像头热管理也是一个需要考虑的大问题。传统摄像头基本都是使用内置 ISP,但一些行业也在使用无 ISP 的摄像头模组,数据直接传输到域控制器,由外部 ISP 进行处理。

ISP 是摄像头产生热量和提升功耗的主要元器件,部分公司提出把 ISP 集成到控制器中进行热管理。

例如安波福提出的解决方案是摄像头保留光学镜头和图像传感器部分,将 ISP 移动到相应的控制器主板中,通过以太网来进行数据传输。很多图像传感器制造商在把 ISP 模块从摄像头模组中移除,来限制摄像头的功耗和热量产生。

与此同时,ISP 被集成到专用的视觉处理器(SoC)中,可以提高图像的成像质量,并且可以同时处理多个摄像头的数据,以此来降低成本。

相信未来单个高精度摄像头的成本会出现大幅下降,后续当高精度摄像头成为标配时,整体成本会有比较大的下降空间。

[1] 《大陆集团发布了自己的第五代车规级摄像头MFC500系列》

http://www.elecfans.com/d/695539.html

[2] 《豪威科技推出两款全新车规级图像传感器平台新品OX08A和OX08B》

http://ep.cntronics.com/guide/4302/5174

[3] 《CenterFusion: Center-based Radar and Camera Fusion for 3D Object Detection》

获取更多评论