万字综述车载摄像头

车载摄像头:自动驾驶之眼

车载摄像头被誉为“自动驾驶之眼”,是ADAS系统、汽车自动驾驶领域的核心传感设备。主要通过镜头和图像传感器实现图像信息的采集功能,可实现360°视觉感知,并弥补雷达在物体识别上的缺陷,是最接近人类视觉的传感器。

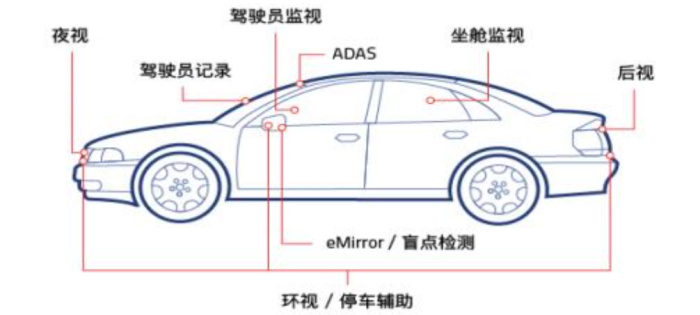

车载摄像头在汽车领域应用广泛,从早期用于行车记录、倒车影像、泊车环视逐步延伸到智能座舱内行为识别和ADAS辅助驾驶,应用场景日渐丰富。

当前全球车载摄像头行业CR3为41%,全球前十企业则占据了96%的市场份额,全球车载摄像头行业集中度处于较高水平。

美国高速公路损失数据研究所(HLDI)预测,到2030年接近50%的汽车将配备ADAS技术。

根据ICVTank,到2025年中国车载摄像头行业规模有望达到230亿,5年CAGR为30%;全球车载摄像头市场规模将有望从2019年的112亿美元增长至2025年的至270亿美元,5年CAGR 达15.8%。

自动驾驶包括感知、判断和执行,而感知是整个过程的源头,是自动驾驶系统的重要模块。在车辆行车过程中,感知系统会通过传感器实时采集周边环境的信息,相当于自动驾驶汽车的「眼睛」,可以帮助汽车实现类似于人类驾驶员一样效果的观察能力。

在自动驾驶车辆中,感知系统主要由摄像头、毫米波雷达、激光雷达(可选,这里主要是怕被特斯拉的粉丝杠)等传感器构成。摄像头作为主要的环境感知传感器起着非常重要的作用, 可以实现 360° 全面视觉感知,弥补雷达在物体识别上的缺陷,是最接近人类视觉的传感器。因此是车载摄像头是自动驾驶领域的关键设备之一。

什么是车载摄像头?

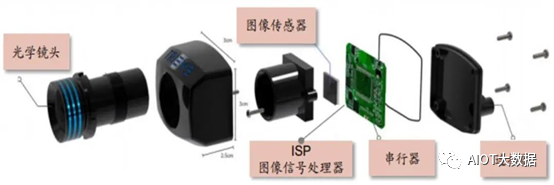

车载摄像头主要的硬件结构包括光学镜头(其中包含光学镜片、滤光片、保护膜等)、图像传感器、图像信号处理器 ISP、串行器、连接器等器件。其结构示意图如图所示:

车载摄像头的结构构成(图片来源:安森美半导体公司)

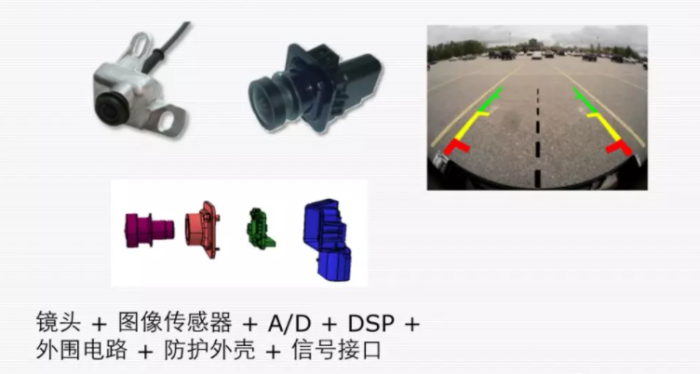

车载摄像头的结构如上图所示,放置车身外面的,就需要组成完整的摄像头,如果是在车内DVR,不用考虑防水,就可以组装成上面的那种摄像头模组。

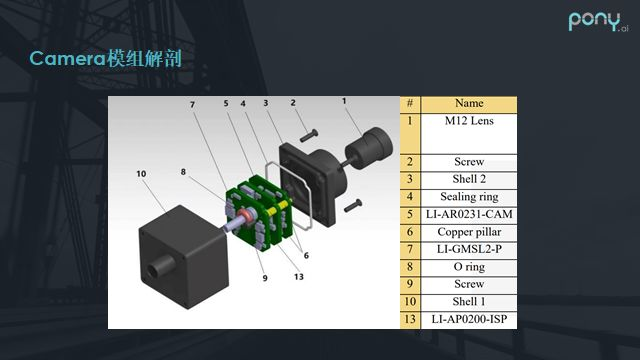

上图是我们比较常见的汽车上使用的相机模组的解剖。除了最外侧的铝壳以及密封圈和镜头之外,其实中间就是比较简单的几层板的设计,通常包括传感器的sensor板,图像处理器的小板,还包括一个串行器的板。为什么需要串行器,是因为通常相机传感器或ISP的图像数据输出总线是MIPI CSI标准,其特点是高速穿行,但是传输总线距离较短,否则无法保证信号的完整性。

所以在车辆上,我们需要将其转换成例如GMSL等适合在车上长距离传输的高速总线标准进行传输,所以相机模组内部通常会通过串行板进行总线的转换。另外同轴电缆既可以用来为模组提供电源,也可以传输图像数据。

光学镜头:负责聚焦光线,将视野中的物体投射到成像介质表面,根据成像效果的要求不同,可能要求多层光学镜片。滤光片可以将人眼看不到的光波段进行滤除,只留下人眼视野范围内的实际景物的可见光波段。

图像传感器:图像传感器可以利用光电器件的光电转换功能将感光面上的光像转换为与光像成相应比例关系的电信号。主要分为 CCD 和 CMOS 两种。

ISP 图像信号处理器:主要使用硬件结构完成图像图传感器输入的图像视频源 RAW 格式数据的前处理,可转换为 YCbCr 等格式。还可以完成图像缩放、自动曝光、自动白平衡、自动聚焦等多种工作。

串行器:将处理后的图像数据进行传输,可用于传输RGB、YUV等多种图像数据种类。

连接器:用于连接固定摄像头。

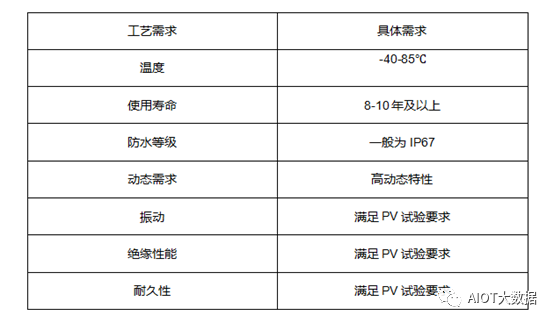

车载摄像头在制造工艺及可靠性要求方面也要高于工业摄像头和商用摄像头,由于汽车需长期工作在恶劣环境中,车载摄像头需要在高低温环境、强振动、高湿热等复杂工况环境下稳定工作,对于工艺制造方面的要求主要如下:

车载摄像头的工艺需求

耐高温 :车载摄像头需在-40℃~85℃范围内都能正常工作,且能适应温度的剧烈变化;

抗震:车辆在不太平坦的路面行驶会产生较强的震动,因此车载摄像头必须能抗各种强度的震动;

防磁 :车辆启动时会产生极高的电磁脉冲,需要极高的防磁性能;

防水 :载摄像头密封要非常严实,满足在雨水中浸泡数日仍可正常使用;

使用寿命 :使用寿命至少为8~10年才能满足要求;

超广角:侧视环视摄像头必须是超广角的,水平视角达 135°;

高动态:车辆行驶速度快,摄像头面对的光线环境变化剧烈且频繁,要求摄像头的CMOS 具有高动态特性;

低噪点:在光线较暗时能有效抑制噪点,特别是要求侧视和后视摄像头即使在晚上也能清楚的捕捉影像。

车载智能前视像头关键参数

探测距离

水平视场角

垂直视场角

分辨率 - 当摄像机摄取等间隔排列的黑白相间条纹时,在监视器(比摄像机的分辨率要高)上能够看到的最多线数,当超过这一线数时,屏幕上就只能看到灰蒙蒙的一片,而不再能分辨出黑白相间的线条。

最低照度 - 即图像传感器对环境光线的敏感程度,或者说是图像传感器正常成像时所需要的最暗光线。它是当被摄物体的光照逐渐降低时,摄像机的视频信号电平低于标准信号最大幅值一半时的景物光照度值。

信噪比 - 输出信号电压与同时输出的噪声电压的比值;

动态范围 - 摄像机拍摄的同一个画面内,能正常显示细节的最亮和最暗物体的亮度值所包含的那个区间。动态范围越大,过亮或过暗的物体在同一个画面中都能正常显示的程度也就越大。

与雷达技术对比有哪些优势

1)相比于毫米波雷达,目前摄像头的主要优势在于:

目标识别与分类 - 目前普通的3D毫米波雷达仅可以检测到前方是否有障碍物,而无法精准识别障碍物的大小和类别;例如:各类车道线识别、红绿灯识别以及交通标志识别等;

可通行空间检测(FreeSpace) - 对车辆行驶的安全边界(可行驶区域)进行划分,主要对车辆、普通路边沿、侧石边沿、没有障碍物可见的边界、未知边界进行划分;

对横向移动目标的探测能力 ,比如对十字路口横穿的行人以及车辆的探测和追踪;

定位与地图创建 - 即视觉SLAM技术,虽然目前也有用毫米波雷达做SLAM的,不过视觉SLAM技术更加成熟,也更有应用前景;

2)在自动驾驶系统中,激光雷达与摄像头感知作用比较类似,但相比激光雷达,其优势为:

红绿灯识别及交通标示识别

成本优势,且算法及技术成熟度比较高

物体识别率高

车载摄像头分布情况:

资料来源:CIOE中国光博会

目前车上搭载的车载摄像头根据安装位置主要分为车载摄像头主要分为前视摄像头、环视摄像头、后视摄像头、侧视摄像头以及内置摄像头五种类别。

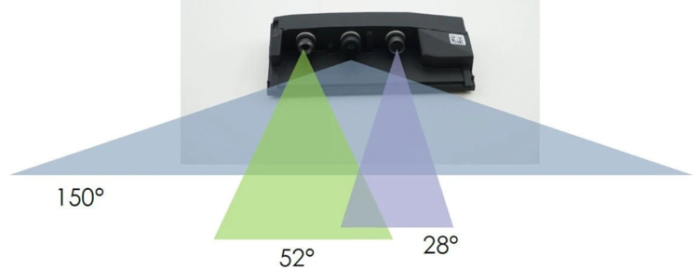

前视摄像头:主要安装在前挡风玻璃上,用于实现行车的视觉感知及识别功能,根据功能又可以分为前视主摄像头、前视窄角摄像头和前视广角摄像头。

前视主摄像头:该摄像头在 L2 的ADAS 系统中作为主摄像头使用。其视场角的一般为 30°、50°、60°、100°、120°,检测距离一般为 150 - 170 m,摄像头输出的格式为 RCCB 或 RCCC。

前视广角摄像头:该摄像头的作用主要是识别距离较近的物体,主要用于城市道路工况、低速行驶等场景,其视场角在 120° - 150°,检测距离在 50 m 左右。在后续 8MP 镜头大规模装车后,无需该摄像头。

前视窄角摄像头:该摄像头的主要作用是进行红绿灯、行人等目标的识别,一般选用窄角镜头,可选择 30 - 40° 左右的镜头。并且该镜头的像素一般和前视主摄像头的镜头像素一致,该摄像头采用窄角度,具有更高的像素密度和更远的检测距离,一般可达 250 m 甚至可探测更远的距离。

在上了 8MP 摄像头后,前视主摄像头的 FOV 可达 120°,该摄像头可能就不需要了。检测距离在 60 m 左右。

环视摄像头:主要安装在车身四周,一般使用 4 - 8 个摄像头,可分为前向鱼眼摄像头/左侧鱼眼摄像头/右侧鱼眼摄像头/后向鱼眼摄像头。用于全景环视功能的显示,以及融合泊车功能的视觉感知及目标检测;常用色彩矩阵为 RGGB,因为有色彩还原的需求。

后视摄像头:一般安装在后备箱上,主要是实现泊车辅助。视场角在 120 - 140° 之间,探测距离大概 50 m。

侧前视摄像头:安装在 B 柱或者车辆后视镜处,该摄像头的视场角一般为 90° - 100°,探测距离大概在 80 m 左右,这个摄像头的主要作用是检测侧向车辆及自行车。

侧后视摄像头:一般安装在车辆前翼子板处,该摄像头的视场角一般为 90° 左右,探测距离也在 80 m 左右,主要用于车辆变道、汇入其它道路等场景应用。

内置摄像头:主要用于监测司机状态,实现疲劳提醒等功能。

其中,前视摄像头价格相对较高,目前市场价格处在 300-500 元水平;其余摄像头价格在 150-200 元左右。

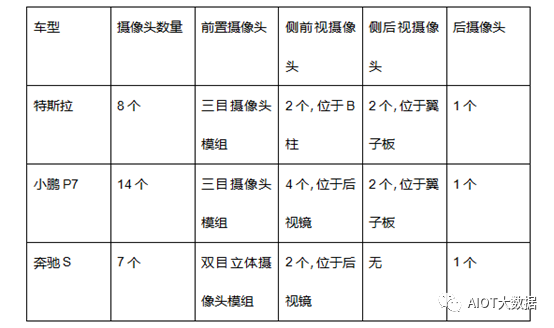

主流厂商车载摄像头搭载方案

从方案中我们可以看到,特斯拉的 8 个摄像头均与行车系统有关联,这与其一直宣传的不依靠激光雷达纯视觉的自动驾驶方案是有较大关联的,特斯拉的这一套方案的最大优势就是:高性价比。特斯拉用了成本非常低的自研 1.2MP 摄像机就实现了 L2+ 级别的自动驾驶。

小鹏 P7 使用了多个摄像头,这一套方案的最大优势就是:可拓展性较强。前期方案在设计时需要提高硬件成本,但是在后期 OTA 升级后,其自动驾驶功能具有非常好的兼容性和可拓展性。

通过这套传感器模型,小鹏实现了具有较好体验的 L2+ 级别的自动驾驶功能,包括小鹏极具特色的高速自主导航驾驶(NGP)和停车场记忆泊车功能。

奔驰 S 级是传统主机厂方案的代表,双目立体摄像头方案是奔驰 S 级最大的优势。相比于单目摄像头,双目摄像头可以计算当前检测目标在 X、Y、Z 坐标下的运动情况,判断检测目标的姿态及目标类型,奔驰在 L2 级别的 ADAS 功能的体验效果也比另外两家好一些。

对已经量产车型的摄像头方案分析中,我们发现其都是使用中低像素摄像头来实现自动驾驶功能。

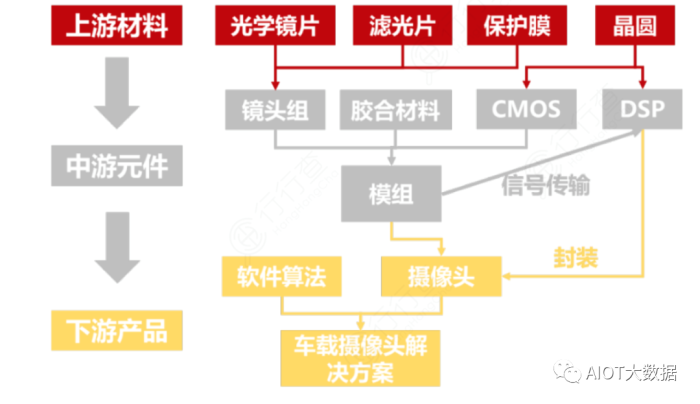

车载摄像头产业链

车载摄像头产业链主要涉及上游材料、中游元件和下游产品三个主要环节。

上游材料中光学镜片、滤光片和保护膜等用于制造镜头组,晶圆用于制造CMOS芯片和DSP信号处理器;在中游镜头组、CMOS芯片和胶合材料等组装成模组,并和DSP信号处理器封装成摄像头产品。

在产业链的这一层,上游供应商已经可以向下游整车或一级供应商客户供应完整的摄像头产品。在车载摄像头产业链中,摄像头和软件算法一起,构成车载摄像头解决方案,应用于自动驾驶汽车中。

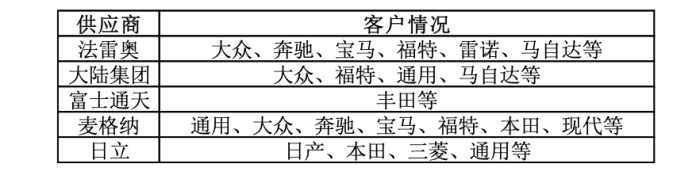

目前车载摄像头市场份额较大的公司均是全球领先的一级零部件供应商,下游客户基本覆盖了全球主要的整车公司。

CMOS在车载摄像头价值量成本占比最高,达到52%;模组封装占比20%、光学镜头占比19%。

CMOS芯片

CMOS(CIS传感器)是主流的车载车载摄像头感光元件方案。相比于CCD感光元件,CMOS的成像质量略逊一筹,但成本低、更省电,因此在像素要求不高的车载摄像头领域广受青睐。

CMOS制造产业链主要细分为设计、代工和封装测试三个环节,最后由模组厂采购组装,整合入摄像头模组再出售给下游应用厂商。

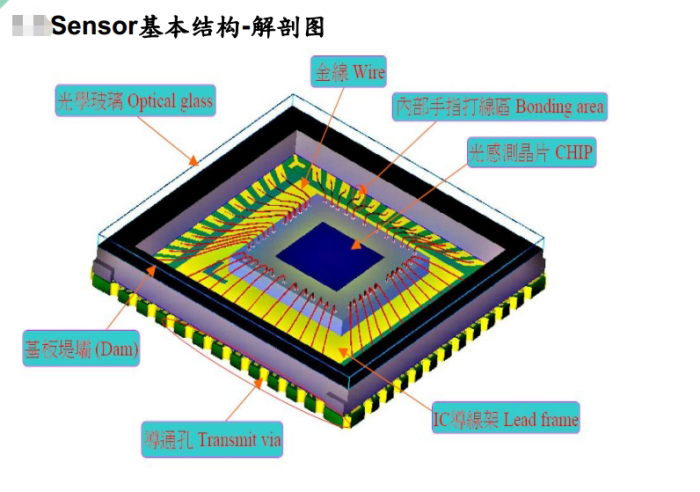

CMOS传感器的构成与关键参数

图像传感器的功能是光电转换。关键的参数有像素、单像素尺寸、芯片尺寸、功耗。技术工艺上有前照式(FSI)、背照式(BSI)、堆栈式(Stack)等。

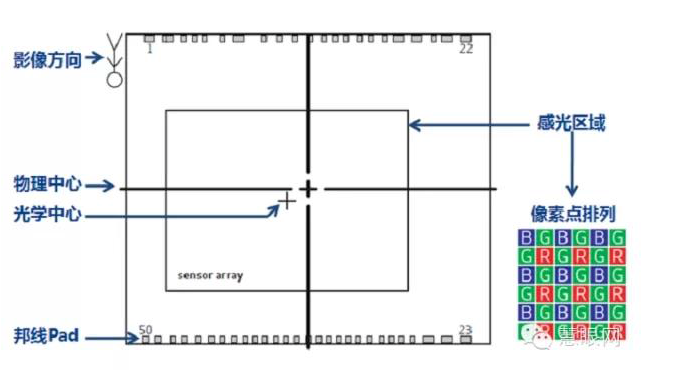

图像传感器从外观看分感光区域(Pixel Array),绑线Pad,内层电路和基板。感光区域是单像素阵列,由多个单像素点组成。每个像素获取的光信号汇集在一起时组成完整的画面。

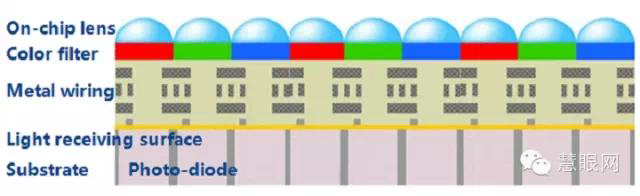

CMOS芯片由微透镜层、滤色片层、线路层、感光元件层、基板层组成。

CMOS芯片剖面图

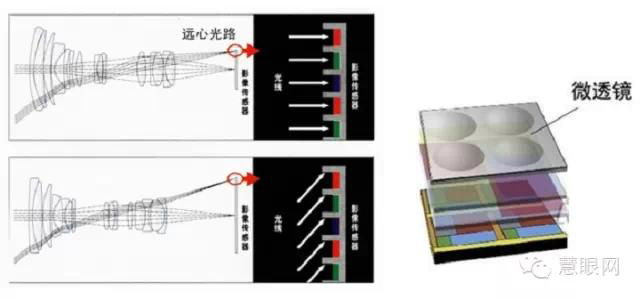

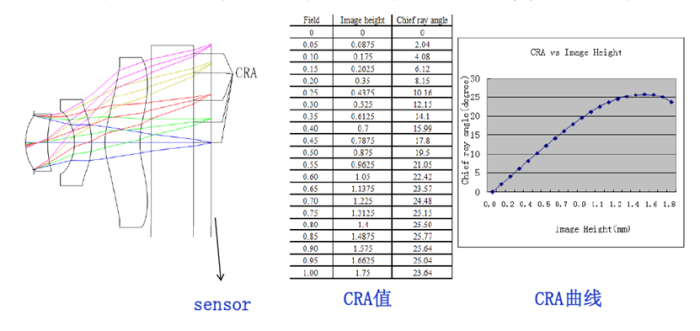

由于光线进入各个单像素的角度不一样,因此在每个单像素上表面增加了一个微透镜修正光线角度,使光线垂直进入感光元件表面。这就是芯片CRA的概念,需要与镜头的CRA保持在一点的偏差范围内。

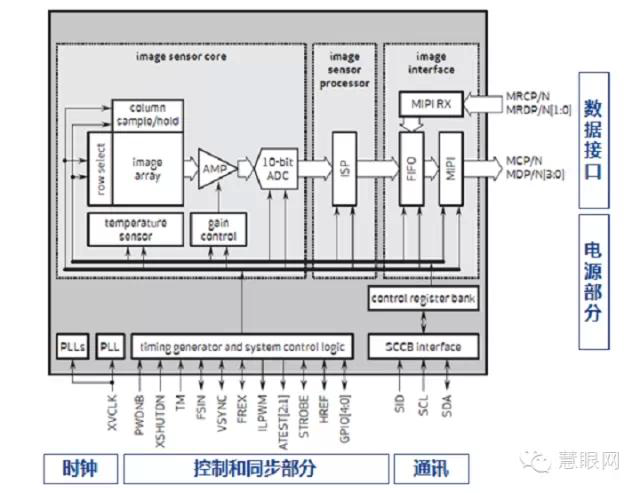

电路架构上,我们加入图像传感器是一个把光信号转为电信号的暗盒,那么暗盒外部通常包含有电源、数据、时钟、通讯、控制和同步等几部分电路。可以简单理解为感光区域(Pixel Array)将光信号转换为电信号后,由暗盒中的逻辑电路将电信号进行处理和一定的编码后通过数据接口将电信号输出。

由于CMOS芯片的像素层的设计工艺类似于模拟芯片,对制造工艺的要求较高,所以索尼、三星等龙头企业均采用IDM模式,而豪威、格科微等中国企业多采用Fabless模式。

代工方面,台积电、华力微、中芯国际、力晶、海力士等代工厂为全球CIS晶圆主要供应商。

封测方面,目前全球CIS封测产能集中在中国台湾,精材、胜丽、同欣电等厂商是主要CIS封测厂商,国内晶方科技、华天科技等也具备CIS封测能力。

根据Yole数据,2019年CIS下游市场增速中,汽车市场同比增长41%,远远超过手机、计算机、安防、工控等其余主要领域。

CMOS的生产制造技术含量高,从全球市场来看,目前主要被外资企业所占据。从竞争格局来看,安森美以36%的市场份额占据第一,国内企业豪威科技以22%位居第二,索尼、松下、三星紧随其后,全球CIS Top3厂商供应超过65%,行业集中度较高。国内企业韦尔股份通过收购豪威科技切入CIS领域,一举成为CIS领域领先企业。

摄像头图像处理ISP初步介绍

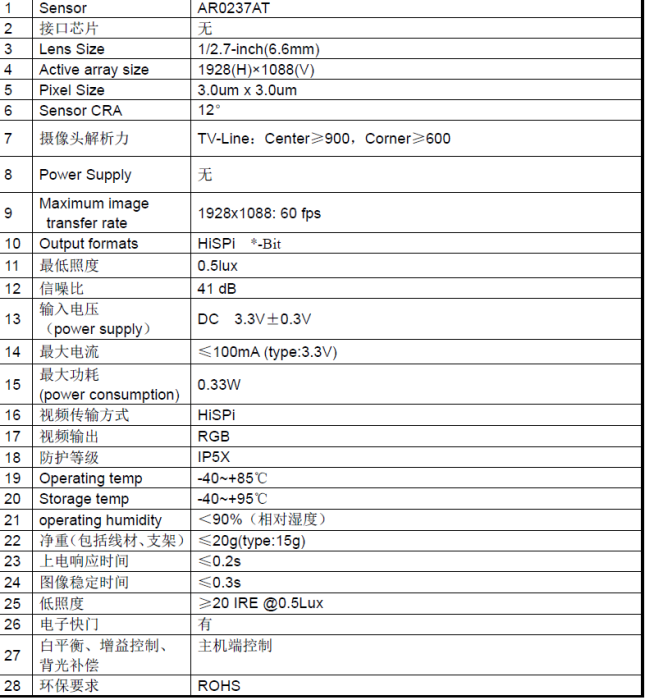

我们看一看车载摄像头模组的关键参数,是不是还有几个没有阐述,比如白平衡、自动增益控制、色彩还原等等,上述摄像头描述就是主机控制,这里就有一个关键器件需要讲解一下,图像信号处理器ISP,这些活都是图像处理器ISP需要干的活。

下图展示了车载系统的基本组成:黄色的箭头代表数据的传输,蓝色的箭头代表控制信号的传输。

相机的图像处理流程大致是这样的:

从相机感受到电荷之后,转化成每个像素的数字信号,它的输出我们可以叫做一个bayer pattern,当bayer pattern进入到ISP之后,经过一系列的图像处理才会变成可以正常预览或者拍照形成的图像。

图像处理中有一些比较关键的步骤,比如我们会做白平衡,因为人眼的视觉会对所看见的颜色做一定的纠正,比如看在黄光照射的范围里,我们看到的黄光打亮白纸不再是白纸。所以很重要的是白平衡的矫正,白平衡的矫正之后会做demosaic,将每个像素的全部颜色通道全部还原回来。

然后每个Sensor的特性或者因为一些原因导致的偏色,需要通过颜色校正的矩阵乘法来做更正。再之后需要转到ycbcr域去做例如针对亮度通道或颜色通道的降噪或者补偿。总体来说,这是一个非常简单的流程,实际上在车载应用中的流程非常复杂,涉及到更多的如HDR多帧曝光,合成,tone mapping等算法。

ISP 放置的位置非常关键:

这里有的是会放置ISP图像处理芯片在摄像头这边,把处理后的信号传输给到主机,有的是不放置ISP芯片,由主机那边的内置ISP芯片进行图像处理,这样摄像头端的散热会好很多,辐射也小。

比如倒车后视摄像头,摄像头距离主机距离都是5-8米,根据车身长度决定,这部分一般是把ISP放置在摄像头模组那端,这样传输过来的信号都是ISP那边进行降噪处理后的信号,抗干扰能力也更强,缺点就是体积会变大,散热要求非常高。

譬如有的行车记录仪DVR摄像头,这部分摄像头距离控制主机CPU非常近,而且对于造型要求也比较高,就会把ISP放置在CPU这边(很多DVR的CPU都内置了ISP芯片),无论是成本还是设计都是最优方案。

前面有提到了,摄像头出来的信号一定要经过ISP处理,那ISP要怎么处理这些信号,有哪些处理,这些其实都是涉及到色彩相关的内容,首先我们进行色彩相关内容的科普,然后再讲解ISP怎么处理这些信号。

camera sensor效果的调整,涉及到众多的参数,如果对基本的光学原理及sensor软/硬件对图像处理的原理能有深入的理解和把握的话,对我们的工作将会起到事半功倍的效果。否则,缺乏了理论的指导,只能是凭感觉和经验去碰,往往无法准确的把握问题的关键,不能掌握sensor调试的核心技术,无法根本的解决问题。

光学部件

镜头组中的光学器件(主要包括镜片、滤光片、保护膜)对摄像头所生成的图像质量方面起到了关键作用。

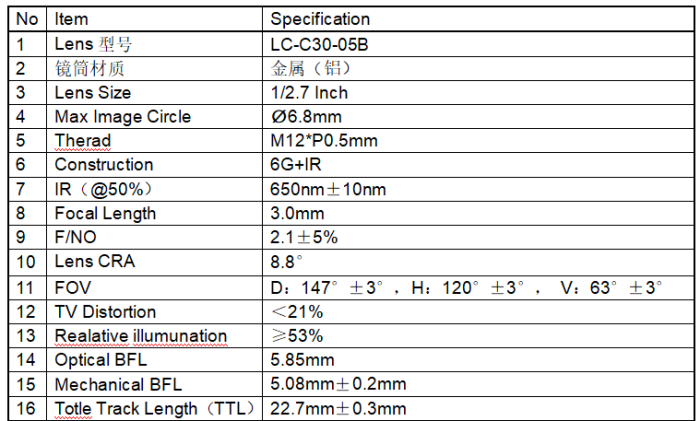

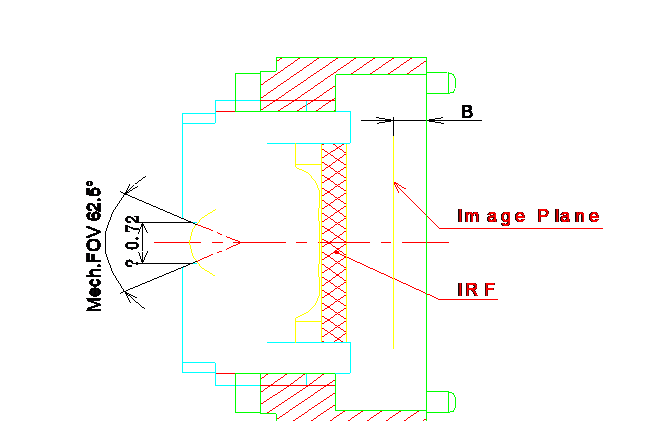

以一款车载DVR的隐藏式宽FOV角度的镜头为例子。

镜筒的材质一般都是金属,但是也有塑胶的,金属的镜筒从质量,耐高低温等各项指标都会更好,但是也有缺点,金属的套筒在螺丝扭的时候会产生金属机械粉末,会有掉入到COMS感光区域的风险,而且金属的套筒硬度比较硬,底板打螺丝的时候容易导致底板有COMS芯片的PCBA变形,从而导致成像后的解析度发生变化。

镜头的材质主要是两种,一种是玻璃,一种是塑胶。

玻璃镜片:以G为缩写,面型多为球面,玻璃研磨加工;

塑胶镜片:以P为缩写,面型多为非球面,注塑加工。

镜头的材质车载里面一般都是使用的是玻璃,玻璃的耐高温,耐擦挂性能都非常好,表面硬度玻璃会好于塑胶,当然玻璃也有缺点,价格贵,而且摄像头整体的厚度变厚了,但是在车载里面这些相对于性能要求而言,都必须要使用到玻璃镜头,所以这里可以看到6G,就是使用6个玻璃片。

镜头的光学参数讲解

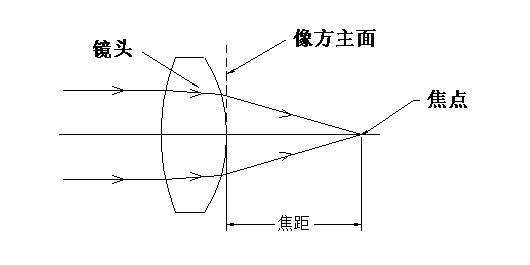

焦距(Focal Length或EFFL)

是指一个光学系统从起像方主面到焦点间的距离, 它反映了一个光学系统对物体聚焦的能力。

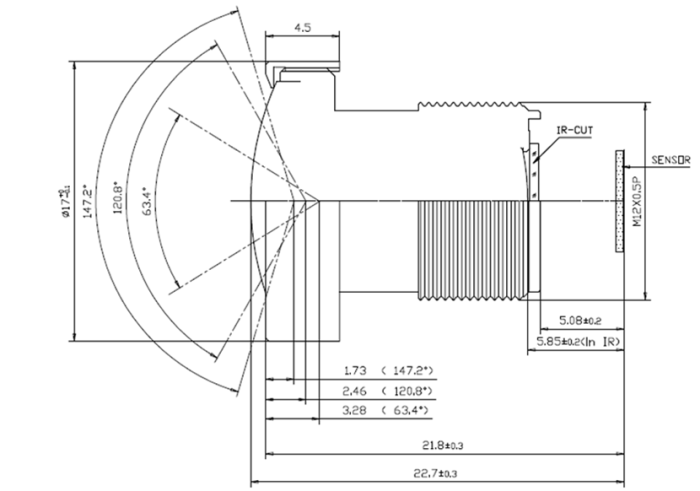

BFL 后焦

镜头最后一镜片面到成像面的距离

这里的如上图所示是 5.85mm;

Mechanical BFL法兰距

镜筒端(前/后)到成像面的距离

这里如上图所示是 5.08mm±0.2mm

镜头总长和光学总长(TTL):

光学总长是指从系统第一个镜片表面到像面的距离; 而镜头总长是指最前端表面(一般指Barrel表面)到像面(例如Sensor表面)的距离.一般来说, 镜头太长或太短其设计都会变得困难, 制造时对工艺要求较高,这个镜头的总长度是22.7mm±0.3mm。

相对孔径(FNo.)

一个光学系统成像亮度指标, 一般简称F数(如传统相机上所标识), 在同样的光强度照射下, 其数值越小, 则像面越亮, 其数值越大, 则像面越暗. 对于一般的成像光学系统来说, F2.0-3.2就比较合适, 如果要求F数越小, 则设计越难, 结构越复杂, 制造成本就越高。这里的FNo为F2.1。

视场角(FOV):

一个光学系统所能成像的角度范围. 角度越大, 则这个光学系统所能成像的范围越宽, 反之则越窄. 在实际产品当中, 又有光学FOV和机械FOV之分, 光学FOV是指SENSOR或胶片所能真正成像的有效FOV范围, 机械FOV一般大于光学FOV, 这是有其他考虑和用途, 比如说需要用机械FOV来参考设计Module或者手机盖的通光孔直径大小。

这里的FOV角度理论上是越大越好,比如做隐藏式行车记录仪DVR的摄像头,这个时候就需要记录到的两边的图像越宽越好,越方便信息的完整性。当然这个FOV的角度直接影响到最终摄像头测距的距离,所以这个FOV角度也是最好根据摄像头的实际应用来选择。

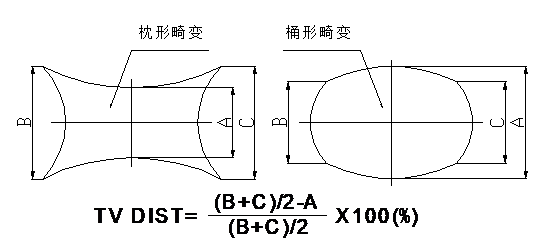

光学畸变(Opt distortion)和TV畸变(TV distortion):

畸变是指光学系统对物体所成的像相对于物体本身而言的失真程度.光学畸变是指光学理论上计算所得到的变形度。

TV畸变则是指实际拍摄图像时的变形程度, DC相机的标准是测量芯片(Sensor)短边处的变形.一般来说光学畸变不等于TV畸变, 特别是对具有校正能力的芯片来说. 畸变通常分两种: 桶形畸变和枕形畸变,比较形象的反映畸变的是哈哈镜,使人变得又高又瘦的是枕型畸变,使人变得矮胖的是桶型畸变。

这个一般都比较重视的是TV失真,越小越好,这样对于后面芯片的处理也就越简单,这里的镜头的TV失真是小于21%。

相对照度(Relative illumination又简写为RI):

它是指一个光学系统所成像在边缘处的亮度相对于中心区域亮度的比值, 无单位. 在实际测量的结果中, 它不仅同光学系统本身有关, 也同所使用的感光片(SENSOR)有关. 同样的镜头用于不同的芯片可能会有不同的测量结果.

这个车载镜头的RI指标是≥53%。

CRA 主光线出射角通过光阑中心光线的成像面入射角

不同的视场具有不同的CRA值,将所有视场的CRA做成一条曲线,即所谓的CRA曲线。图纸中所示的CRA值为Sensor有效像高处的数值。

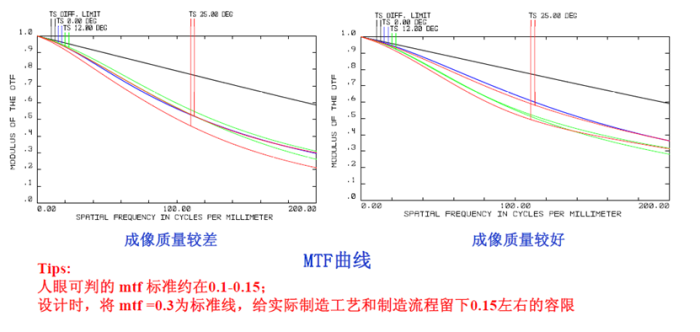

MTF:

它从一定程度上反映了一个光学系统对物体成像的分辨能力.一般来说, MTF越高, 其分辨力越强, MTF越低, 其分辨力越低.由于MTF也只是从一个角度来评价镜头的分辨率,也存在一些不足, 故在目前的生产中, 大多数还是以逆投影检查分辨率为主。

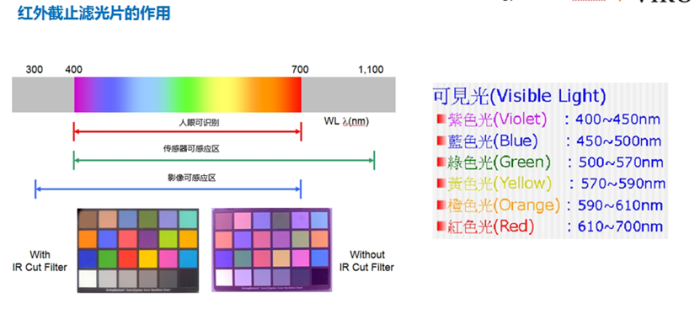

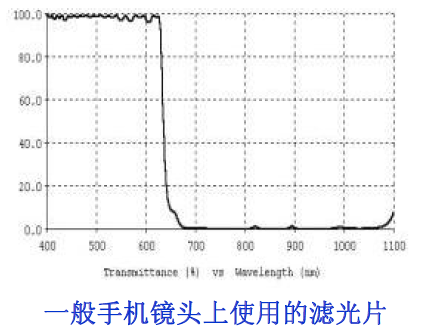

IR Filter(滤光片):

它主要用于调整整个系统的色彩还原性. 它往往随着芯片的不同而使用不同的波长范围, 因为芯片对不同波长范围的光线其感应灵敏度不一样.对于目前应用较广的CMOS和CCD感光片它非常重要, 早期的CCD系统中, 采用简单的IRF往往还不能达到较好的色彩还原性效果。

IR-Cut:透过率为50%时的红外光线频率,650±10nm @ T=50%

所以这里可以看到车载摄像头的镜头的红外滤光片基本上都是650nm±10nm的滤光片。

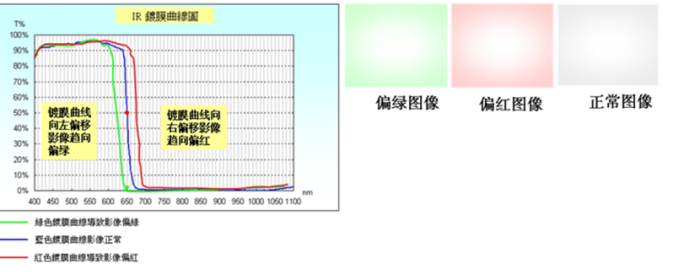

IR镀膜的规格对镜头的色彩还原性有较大的影响,另外结合sensor的特性,对镀膜进行优化,会改善镜头色彩还原能力,所以在有的摄像头拍照出来的色彩还原效果比较差的时候,软件优化都无能为力的时候,可以考虑IR镀膜来调整。

镜头主要用于将图像聚焦到传感器上,作为核心元件,其壁垒在于焦距、视场角、光圈、畸变、相对照度、分辨率等。由于室外环境严苛,车载镜头在形状上要有良好的热稳定性,所以镜头主要使用玻璃而非塑胶材质。

光学部件行业整体处于成熟期,行业集中度相对较高,大多是传统的相机镜头生产商。根据Yole Development, 全球CR4约为40%~50%左右。

在全示车载摄像头镜头组全球市场,舜宇光学占据第一的市场份额,2004年开始布局车载镜头市场,2012年开始做到了全球车载镜头出货量的第一并保持,跟随其后的主要产商包括日本世光、日本康达智、富士胶片等。

国内光学镜头领域主要厂商主要有联创电子、欧菲光、福光股份、力鼎光电等。水晶光电(滤光片、保护膜)、欧菲光(滤光片)、海泰(保护膜)等企业正在向海外龙头发起挑战,在国内新势力崛起的背景下,有望乘“车载”之东风,引领光学部件环节的国产替代。

摄像头模组封装

车载摄像头模组的封装工艺难度高于手机,首要需保障驾驶安全,对其在驾驶期间、不同工作环境下的使用稳定性有较高的要求。因此,相比其他领域,车载摄像头的产品安全标准更高,生产技术要求更高,工艺难度大。

从竞争格局来看,当前全球车载摄像头行业市场份额前三为松下、法雷奥和富士通:其中松下所占市场份额最大,达到20%;法雷奥和富士通的市占率分别为11%和10%。

全球主要摄像头供应商的客户情况:

资料来源:东方证券

该领域主要玩家还包括:信利国际、海康威视、比亚迪、联合光学、德赛西威等。

车载摄像头的未来改善需求

摄像头的像素大幅提升,带来的不光光是对芯片算力等性能的要求,还带来了对于功率、热管理等层面的需求。为了实现更好的性能,摄像头需要更大功率的电源,因此摄像头热管理也是一个需要考虑的大问题。传统摄像头基本都是使用内置 ISP,但一些行业也在使用无 ISP 的摄像头模组,数据直接传输到域控制器,由外部 ISP 进行处理。

ISP 是摄像头产生热量和提升功耗的主要元器件,部分公司提出把 ISP 集成到控制器中进行热管理。

例如安波福提出的解决方案是摄像头保留光学镜头和图像传感器部分,将 ISP 移动到相应的控制器主板中,通过以太网来进行数据传输。很多图像传感器制造商在把 ISP 模块从摄像头模组中移除,来限制摄像头的功耗和热量产生。

与此同时,ISP 被集成到专用的视觉处理器(SoC)中,可以提高图像的成像质量,并且可以同时处理多个摄像头的数据,以此来降低成本。

相信未来单个高精度摄像头的成本会出现大幅下降,后续当高精度摄像头成为标配时,整体成本会有比较大的下降空间。

附:特斯拉图像识别原理阐述

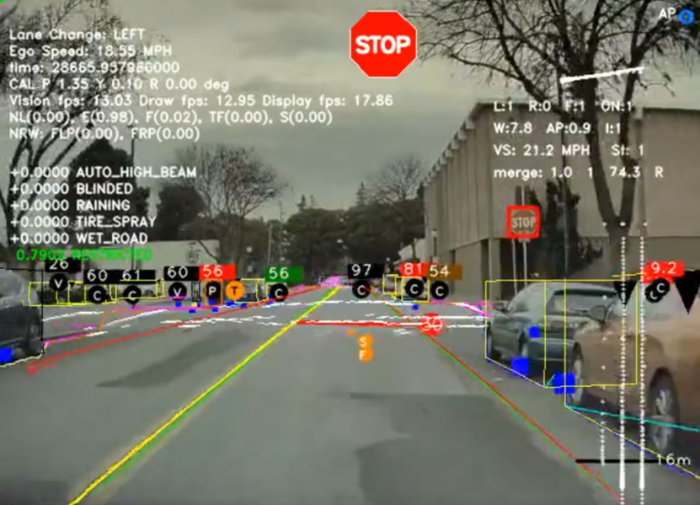

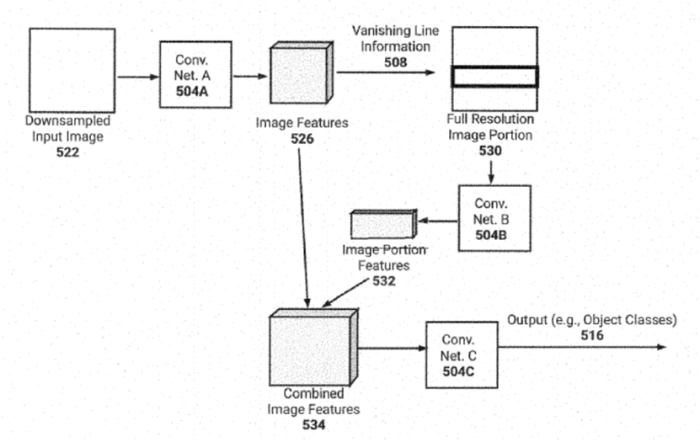

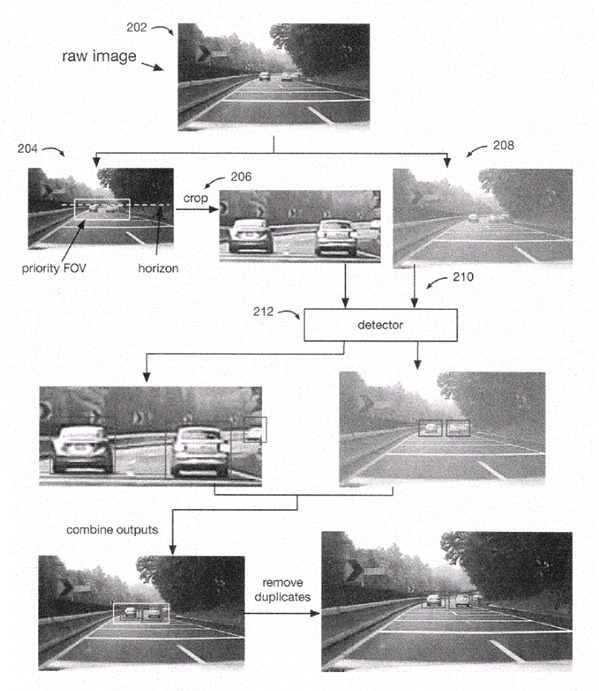

特斯拉利用8个摄像头来识别现实世界中的物体。摄像头获取的图像包括行人、其他车辆、动物或障碍物,这不仅对特斯拉车辆驾驶员的安全很重要,对其他人也很重要。专利称,重要的是,摄像头能够及时准确地识别这些物体。

特斯拉专利框

特斯拉专利演示

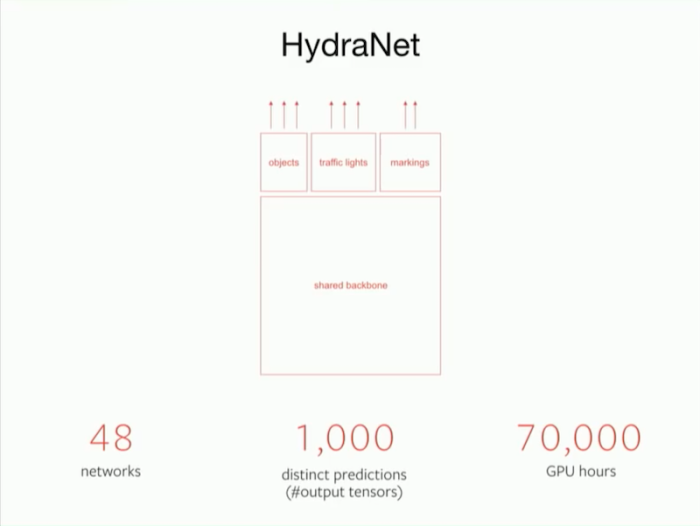

从算法的代码层面来说,特斯拉把它们的深度学习网络称为HydraNet。其中,基础算法代码是共享的,整个HydraNet包含48个不同的神经网络,通过这48个神经网络,就能输出1000个不同的预测张量。理论上来说,特斯拉的这个超级网络,能同时检测1000种物体。完成这些运算并不简单,特斯拉已经耗费了7万个GPU小时进行深度学习模型训练。

虽然工作量很大,但由于大部分工作由机器承担,特斯拉的人工智能团队仅由几十人组成,与其他自动驾驶公司数百人甚至数千人的规模相比,确实规模不大。

完成2D的图像还不算牛掰的,毕竟云端有超级计算机可以去训练,本地的芯片也是自己开发的,可以很好的匹配算法,特斯拉真正牛掰的地方,通过视觉完成3D的深度信息,并可以通过视觉建立高精度地图,完成一些底下停车场的附件驾驶场景。

特斯拉全车共配备了8个摄像头,一个毫米波雷达和12个超声波雷达,监测外部环境,向自动驾驶电脑实时传送信息。

特斯拉车外传感器

简单来看,特斯拉的摄像头、毫米波雷达、超声波雷达以及惯性测量单元记录下当前车辆所处的环境数据,并将数据发送给特斯拉的自动驾驶电脑。自动驾驶电脑在进行算法的计算之后,将速度和方向信息传递给转向舵以及加速、制动踏板,实现对车辆的控制。

不过,在日常行驶过程中,摄像头作为传感器捕捉的内容都是二维图像,并没有深度信息。

也就是说,虽然二维图像已经可以区分公路和路旁的人行道,但并不知道现在车辆距离“马路牙子”还有多远。由于缺失这样一个重要信息,自动驾驶的运算可能并不准确,操作可能出错。因此,捕捉或者建立一个三维的图景很有必要。

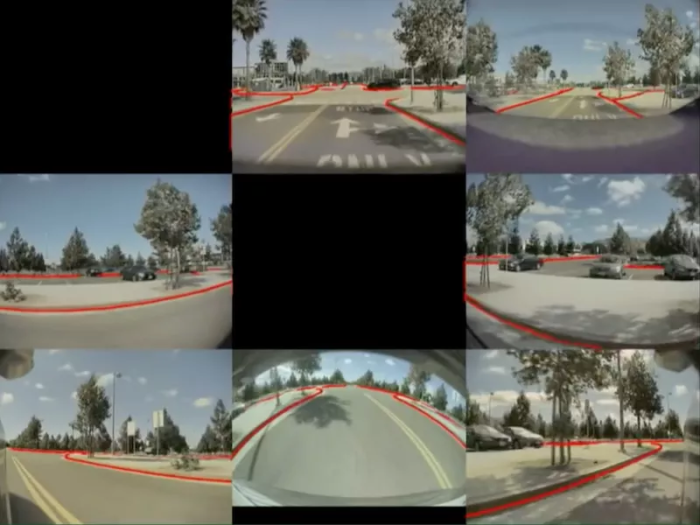

特斯拉使用三目相机的,它可以通过比较两个摄像头图像的差异判断物体的远近,获得物体的深度信息。通过中央处理器对输入图像进行感知、分割、检测、跟踪等操作,输出给导航网络端进行语义建图及匹配定位,同时通过目标识别形成相应的ADAS系统目标属性。

特斯拉还有更厉害的地方,那就是算法可以预测流媒体视频中每一个像素的深度信息。也就是说,只要算法足够好,流媒体视频更加清晰,特斯拉的视觉传感器所捕捉的深度信息甚至可以超过激光雷达。

在实际的自动驾驶应用中,泊车入位和智能召唤两个使用场景下就能充分利用这套算法。在停车场行驶时,车辆之间的距离很小,即使是驾驶员驾驶,稍不留神也很容易出现刮蹭事故。对于机器来说,停车场场景的行驶更加困难。在预测到深度信息之后,车辆可以在超声波雷达的辅助之下,快速完成对周围环境的识别,车辆泊车就会更加顺利。

在完成深度信息的预测之后,这部分信息会显示在车机上,同时也会直接参与控制转向、加速、制动等驾驶动作。不过,转向、加速、制动这些驾驶策略没有固定的规则,有一定灵活性。因此,自动驾驶的驾驶策略没有最佳,只有更好。

获取更多评论